Bara lite drygt två månader efter att Google först tillkännagav sin nya stora språkmodell Gemini har företaget nu introducerat Gemini 1.5 som erbjuder ”dramatiskt bättre prestanda”. Sundar Pichai skriver att Gemini 1.5 är i nivå med Gemini 1.0 Ultra fast utan att kräva samma intensiva beräkningskraft, tack vare en högre effektivitet.

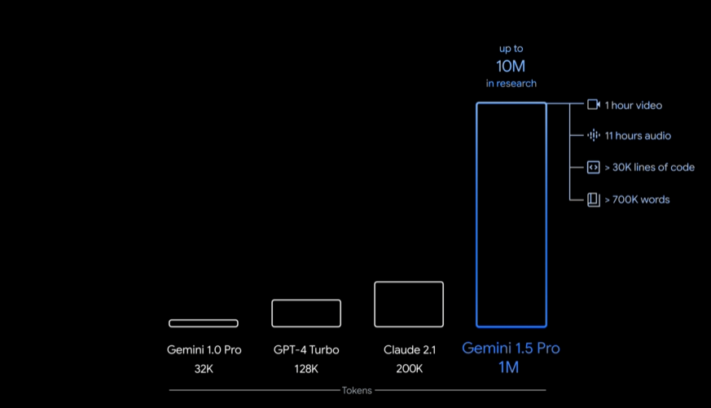

En viktig nyhet är att språkmodellen kan hantera enorma mängder information samtidigt, något tillkännagivandet kallar ”long-context understanding”. Gemini 1.5 kan hantera upp till en miljon tokens, vilket ska vara rekord i branschen och möjliggöra längre sammanhängande kontext och nya förmågor.

This new generation also delivers a breakthrough in long-context understanding. We’ve been able to significantly increase the amount of information our models can process — running up to 1 million tokens consistently, achieving the longest context window of any large-scale foundation model yet.

Longer context windows show us the promise of what is possible. They will enable entirely new capabilities and help developers build much more useful models and applications.

Google skriver att Gemini 1.5 baseras på företagets ledande forskning kring Transformer- och MoE-arkitekturerna. En traditionell Transformer fungerar som ett enda stort neuronnät, medan MoE-modellen är indelad i mindre ”expert”-neuronnät.

På så vis kan MoE-modeller bara aktivera de mest relevanta neuronnäten, det vill säga ”experterna”, beroende på vad språkmodellen fått för input från användaren. Metoden ökar effektiviteten markant. Vad innebär då allt detta för användare? Vi kan helt enkelt räkna med en smartare och mer effektiv digital assistent och chattbott med generativ AI från Google framöver, som kan hantera större mängder data samtidigt.

Till en början kommer Gemini 1.5 endast förhandsvisas för utvecklare och företagskunder via AI Studio och Vertex AI, men språkmodellen ska få en bredare lansering längre fram. Mer information finns på blog.google.

An AI model’s “context window” is made up of tokens, which are the building blocks used for processing information. Tokens can be entire parts or subsections of words, images, videos, audio or code. The bigger a model’s context window, the more information it can take in and process in a given prompt — making its output more consistent, relevant and useful.

)